Inteligência Artificial (PL 2338/2023 - Câmara dos Deputados)

Relatório de Audiência Pública realizada no dia 08/07/25 para debater Proteção de diretos fundamentais e novas tecnologias

RADAR BRASÍLIA

André Fortes Chaves

7/9/20257 min ler

COMISSÃO ESPECIAL DO PL 2338/2023 – INTELIGÊNCIA ARTIFICIAL

Audiência Pública para debater Proteção de diretos fundamentais e novas tecnologias

André Filipe Batista, Professor e Diretor de Tecnologia no INSPER: O Brasil tem a oportunidade de assumir a liderança no tema da regulação de Inteligência Artificial, dando previsibilidade a quem inova e estimulando o ambiente de negócios.

Propostas:

Inclusão de conceitos no art. 4º do PL, que fala sobre risco sistêmicos e efeitos adversos negativos, mas não traz os respectivos conceitos. Trazer três conceitos no texto da lei implica em maior segurança jurídica, previsibilidade e redução de interpretações específicas de autoridades na judicialização. Conceitos: efeito adverso; limitação ou contraindicação de uso; e evento adverso.

Modificação do art. 18, I, f. fala sobre a proporcionalidade e o risco do sistema em si. Proposta: acrescentar a alínea g, segundo a qual o desenvolvedor da IA disponibilize um documento informativo com uma linguagem simples, proporcional ao risco do sistema e ao porte do agente, contendo orientações sobre o sistema de IA (um paralelo ao que se vê na farmacovigilância, como uma bula, com indicações, contraindicações, quando o uso é recomendado, eventuais efeitos adversos e informações de contato para comunicação daqueles incidentes). A ideia de deixar já na lei a propositura de um documento informativo e com mínimo necessário, respeitando grau de risco e porte do agente é evitar múltiplas interpretações no futuro e dar segurança no ambiente de inovação.

Modificação do art. 26. Artigo está bem escrito, mas peca por não deixar claro o que é o monitoramento contínuo do ciclo de vida de inteligência artificial. Precisa estar claro que é praticamente impossível prever ou mitigar todos os riscos de uma IA no momento da sua concepção. Então, a avaliação de impacto dela é durante a sua execução, por meio das ferramentas de controle. Precisa estar previsto no texto para evitar interpretações casuísticas.

São propostas que não trazem travas excessivas. São proporcionais aos riscos e aos portes dos agentes. Por exemplo, as startups não terão o mesmo nível de obrigação e o texto já prevê isso.

Alisson Alexsandro Possa – Pesquisador no Instituto Brasileiro de Ensino, Desenvolvimento e Pesquisa – IDP: As tecnologias não são neutras e precisamos reconhecer algumas questões quer gostemos ou não. Precisamos de um texto com parâmetros mínimos no Brasil. Até porque se não tivermos iremos pulverizar legislações no Brasil a nível estadual e municipal, fragmentando o arcabouço para IA no país. O PL 2338/2023 não é uma mera cópia do AI Act visto que dispõe de direitos fundamentais próprios, uma marca essencialmente brasileira. Além disso, o PL prevê apenas três categorias de riscos, diferente do AI Act, que prevê quatro.

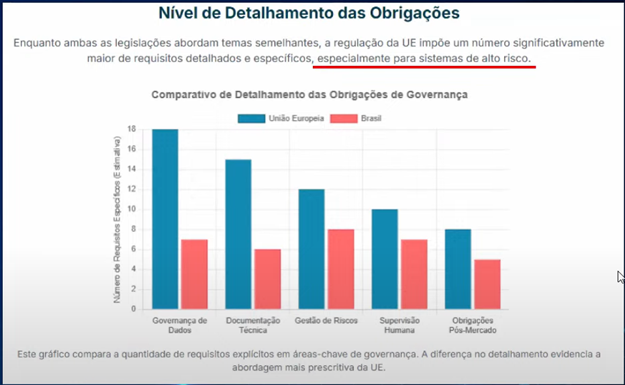

Com relação à crítica: “se a União Europeia não está conseguindo fiscalizar o AI Act, será que o Brasil vai conseguir?”, cabe uma reflexão sobre as obrigações previstas em cada modelo:

Além disso, as nossas obrigações são para alto risco somente.

Renê Guilherme da Silva Medrado, Diretor Presidente do Instituto Brasileiro de Estudos de Concorrência, Consumo e Comércio Internacional – IBRAC: Existe uma preocupação de fazer um rol bastante amplo de direitos. Uma ponderação que se pode colocar é que já existe na realidade brasileira já estão previstos em outros diplomas como a própria Constituição. Eles se aplicam e o projeto de lei acaba reafirmando isso. Portanto, parece atingido o propósito de salvaguardas de direitos. Outro ponto interessante também para a salvaguarda é a ferramenta do sandbox regulatório, na medida em que permite maior flexibilidade e possibilidade de adaptação, uma vez que será uma tecnologia bastante dinâmica.

Vemos do PL que existem algumas normas. Especialmente alguns requisitos complexos de governança e de conformidade. É verdade que existem previsões de que esses requisitos sejam adequados, mas isso demandará uma atuação bastante próxima e vigilante por parte do regulador que venha a ser constituído.

Há um interesse do país em competir por investimentos. Se a regulação for mais excessiva do que de outros países que possam vir a absorver esses investimentos em IA, é necessário um cuidado para que não se perca investimentos.

Se temos menos obrigações do que a UE, por outro lado temos mais obrigações que o Japão, que adota uma abordagem principiológica. Então, é necessário um equilíbrio.

No relatório feito sobre plataformas digitais o Ministério da Fazenda afirma que deve-se ter o cuidado para que não haja uma perda de produtividade com o uso limitado de IA.

Christian Perrone – Diretor de Relações Governamentais da Microsoft Brasil: Trouxe dado sobre a relevância da IA no Brasil. 18.6 milhões de pessoas no Brasil com deficiência sendo que 8 milhões delas são pessoas com deficiência visual. Ainda que a IA ainda não resolva o problema dessas pessoas, ela facilita e gera maior autonomia e independência. A IA não é uma tecnologia como outra qualquer. Ela é na verdade uma tecnologia de propósito geral. Ela não é um setor específico. A discussão que nós estamos falando é uma discussão sobre a nova economia não só do Brasil, mas do mundo. Uma economia que vai afetar transversalmente não apenas o setor de tecnologia, mas de agro, educação, saúde e até serviços públicos. Portanto, o PL pode olhar não apenas para as relações consumeristas, mas para criar confiabilidade e responsabilidade dentro dessa cadeia, nas relações B2B.

ANDRÉ BECK, Diretor de Operações e Diretor Financeiro da Widelabs: Entendem que o texto do PL é super interessante, uma iniciativa fundamental para regular nossa IA. No entanto, cabem alguns apontamentos. Como regular sem travar a inovação nacional?

Cinco sugestões:

Clareza conceitual e avaliação de risco focada no uso final – falta distinguir no PL o que é um sistema de IA e um modelo de IA, diferenciação que é fundamental e que precisa estar mais clara. Os modelos de IA são os motores que fazem as milhões de tecnologias funcionarem. E o Brasil tem sim e essa distinção no PL é necessária. Deve-se incluir um dispositivo onde a classificação de riscos dos sistemas de inteligência artificial deveria considerar prioritariamente a finalidade do uso específico no contexto da aplicação. Não uma aplicação genérica para todo e qualquer risco e modelos fundacionais de propósito geral.

Transparência e explicabilidade realistas – o mundo inteiro já reconhece que o modelo fundacional não é explicável. Isso é uma constatação mundial. O PL exige que os sistemas sejam explicáveis, mas muitos já não são. Se a gente exigir isso vamos estar travando a inovação. Incluir um parágrafo no PL que reconheça a limitação técnica atual, incentivando o desenvolvimento nacional de tecnologias de auditoria e interpretabilidade para modelos de IA, em vez de exigir uma explicabilidade completa que hoje é tecnicamente inviável.

Sandbox regulatório – propõe-se que seja um ambiente reservado para casos extremamente específicos, com riscos genuinamente elevados e desconhecidos. Para os demais, a classificação de “alto risco” deve ser baseada em critérios técnicos, objetivos e claros, focados no potencial de dano real e direto a direitos fundamentais. Uma avaliação centralizada e genérica é operacionalmente inviável e pode paralisar setores críticos, como saúde e justiça.

A lei precisa criar mecanismos explícitos de apoio e proporcionalidade. Neste sentido, propõe-se estabelecer regime de conformidade simplificado para micro, pequenas e médias empresas nacionais, com isenção de obrigações burocráticas para sistemas de baixo risco.

Mecanismos de soberania na prática, como mecanismos para priorizar o Brasil. Prioridades em compras públicas, análise de impacto soberano (para adoção de tecnologia estrangeira em órgãos públicos e setores estratégicos), fomento e certificação (criar um selo de “conformidade e soberania”) e governança inclusiva (garantir a participação efetiva de startups e empresas de tecnologia brasileiras no futuro órgão gestor da política de IA.

Emanuella Ribeiro – Analista de Pesquisa em Políticas Públicas do Instituto Alana: Preciso pensa como que a gramática do PL 2338/23 vai dialogar com o Estatuto da Criança e do Adolescente, estes que são sujeitos de direitos garantidos a todos e de proteção especial. Tem que ser reconhecida a hiper vulnerabilidade deles, inclusive no contexto de IA, bem como a responsabilidade compartilhada pela proteção e promoção de direitos.

Quanto ao texto do PL, sugere-se preservar que o projeto tenha compromisso com a proteção integral de crianças e adolescentes (art. 2º, XVII); a prevenção, precaução e prestação de contas e responsabilização (art. 2º, IX, X, XI, XII) e compromisso com direitos e inovação em prol da promoção de direitos de pessoas com deficiência.

Regulação de alto risco que contempla situações que impactam direitos de crianças e adolescentes: IA e direito a educação (art. 14, II) e acesso a serviços (art. 14, IV). Também é importante manter o art. 15, III e X, que têm critérios de alto risco para quando a IA impacta os direitos de crianças e adolescentes ou de pessoas vulneráveis. É positivo o PL ter um texto flexível com rols exemplificativos, justamente para lidar com as mudanças da sociedade.

Quanto às sugestões, recomenda-se uma melhora na redação para ter uma melhor congruência com a gramática dos direitos de criança e adolescentes. Traz-se sugestões com base em disposições que já estiveram no texto do Senado Federal, como o princípio da prioridade absoluta.

Janine Mello dos Santos – Ministra substituta do Direitos Humanos e Cidadania: Especialmente promissor ver que esse projeto parte de uma diretriz objetiva e de que o desenvolvimento, o uso e o fomento precisam se dar com base na centralidade da pessoa humana. Estamos diante de uma escolha política, ética e jurídica que deve ser reconhecida e valorizada. Representa uma tentativa de posicionar o país frente a novas tecnologias não apenas no sentido de regular a sua aplicação, mas de fazê-lo à luz da justiça social e do compromisso com a democracia. Inovação e regulação não são conceitos que estão em oposição.